### 기술세션 | AI에이전트 시스템 구축 및 관리를 위한 통합 플랫폼

- Mosaic AI 개요

- ai builder ( 노코드기반 )

- AI playground : 개발 설정하는 곳

- AI 시스템 평가 : 문제점 확인후 수정후 재배포, AI Judge

- MLflow Tracing을 통해 디버깅, 로깅으로 추적

- Agent Evalution 리뷰앱 : 이해관계자와 빠른 피드백에 도움

- Mosaic AI 게이트웨이

- AI/BI 대시보드, 레이크하우스 모니터링 (운영관점)

### 기술세션 | LLMOps in Databricks: AI Agent를 Production 환경에 배포하기 위한 고려사항

- FACTSET FQL 을 자연어로 생성하는 프로젝트 사례

- GPT4 : 59%, 15s >> 85%, 6s

- Mosaic AI Model Training ( 모델 학습후 배포 )

- 모델 배포 3가지 : custom Models 데이터브릭스 자체적 기능 / Foundation Models 메타와 직접적인 구현 가능한 기능들 / External Models 상용AI모델을 사용할 때

- Governance : limit 공격적 요청수를 제한하여 리스크 관리

- 13 RAG : 적절한 문서를 탐색하는 것이 key, 벡터DB를 많이 활용함

Anthropic과 협업해서 개발한 기능임

Delta Table 특징 : vector에 컬럼을 추가해서 활용가능

- 23 OpenAI / Rang Chain : 데이터브릭스에서 자체 개발한 텍스트기반 SQL구성 Genie라고함

- 33 Tool Calling : tool 또는 지정된 함수를 이용하면 할루시네이션을 줄일 수 있음

- AI Playground에서 바로 응답을 확인할 수 있다.

- 평가 Metric을 제공을 하고 있음

- 평가는 개발단계에서 평가 / 배포후 단계에서 성능을 평가 이렇게 2가지로 구분됨

- MLflow Trace UI에서 테이블로 저장된 로그를 보는 화면을 제공함

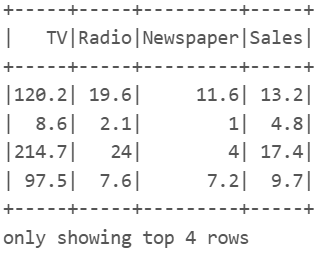

### 파트너 스폰서 세션 | KT - Databricks를 활용한 네트워크 기지국 전력 제어 모델 개발 사례

- 01 Intro

- 02 기지국 트래픽 수요예측

- 무선 네트워크 풀질 관리 / 네트워크 안정성 확보

- Uplink : 사진 업로드, 음성 전송, 메시지 보내기

- Downlink : 유튜브 영상 시청, 음악 감상, 웹 서핑

- 트랙픽 수요 = Uplink 수요 + Downlink 수요

- 03 기지국 트래픽 수요 예측 모델링

- 시간적 특징 / 공간적 특징 / 이벤트 변수 / log 변서(과거 트래픽 평균)

- 04 databricks datapipeliine 구성

- MLOps Workflow 구성하는 단위별로 Python Script 구성

- 변동성이 많은 KT같은 회사는 모니터링이 중요했다.

### 파트너 스폰서 세션 | AWS = Better Together Databricks on AWS

- 생산성 강화 : 다양한 배경 이미지/영상 생성, 프로모션 활용

- 운영 개선 : DDI EDS와 Amazon Bedrock 통합 시연 데모

- 창의/창조 : AI 기반 디지털 휴먼 구성

- 고객 경험 강화 : 쇼핑 어시스턴트 amazon

사용자가 무슨 상품을 살지 물어보고 AI가 대답해서 원하는 물건을 찾아갈 수 있게 도와줌

- Agent 와 Agentic 차이 : 추론이 있으면 Agentic

- Agentic AI Use case 1 : RAG

- Agentic AI Use case 2 : Text2SQL

- Agentic AI Use case 3 : Text2Image

### 기술 세션 | Databricks 관리형 MLflow: AI 모델, LLM과 생성형 AI의 혁신적 관리 플랫폼

- MLflow Components : 1.Tracking / 2.Project / 3.Models / 4.Model Registry

- 1. ML워크플로우를 더욱 관리하기 쉽게 만들기

- 실험 및 실행관리 / Custom Logging / Auto logging

- 3. MLflow Models

- 디렉토리 구조로 관리함

- 4. A centralized model store

- 하나의 협업 허브 / 수명 주기 관리 / 가시성 및 거버넌스

- catalog.schema.model

- Databricks AutoML 소개

- 모두를 위한 빠르고 간소화된 머신 러닝

- 데이터팀의 통제력을 유지하면서 역량을 강화할 수 있는 A glass-box 솔루션

- LLM-as-a-judge : 평가 및 디버깅 전후 비교

### 고객사례 | KCD의 Text2SQL AI Agent를 활용한 데이터 민주화 구축

- 문제 : 작은 조직의 회사가 cashnote 서비스를 운영하면서 점점 확장되면서 문제가 생김

- Product Overview : KCD의 데이터 민주화

- 데이터분석팀의 생산성을 확보하고 전문적인 기술 지식이 없는 누구나 데이터 기반 의사결정

- unity Cattalog

- 가장 중요한 것은 회사의 비즈니스를 깊이 이해하고, 그에 맞춰 data ontology를 잘 설계하는 것

- 이후에는 Text2SQL 프로세스를 효과적으로 운영하기 위해 온톨로지 기반하여 테이블 구조를 단순화하고 정교하게 다듬는 것이 핵심

- Text2SQL : Just Use the AI/BI Genie

- 프롬프트 최적화 : 스키마 및 테이블 정보 전달 방식 개선

- 보안 강화 : 테이블 접근과 LLM 프롬프트 내 데이터 보호

- 실행 시간 단축 : 외부의 복수 API호출로 인한 지연 최소화

- 할루시네이션 문제 해결 : 사용자 경험 침 신뢰성 보장

- 효과 : 비용 10%, 해결해준 비율 54%해소

### 고객사례 | Bagelcode의 데이터 에이전트 DAVIS와 지니를 활용한 데이터 기반 의사 결정 가속화

- 포커스 : 빠른 의사 결정 (ex, 광고 집행)

- 데이터 기반 의사 결정을 더 바르게 할 수 없을까 ?

- DAVIS : 자연어 기반 데이터 서비스

접근성 / 사용성 / 빠른 구현

- 기능 소개 : SQL Queries / Tablau Dashborad 접속하지도 않고 데이터 받아옴

- Genie 더 똑똑하게 만들기

- Stay Focused

- 단일 게임에 대한 데이터 구조

- Mart Table만 사용해서 Genie를 구축하기로 집중함

- Plan to iterate

- Genie의 역질문 수집하기

- Build on well-annotated Tables

- dbt 모델 ( .sql+.yml)

- 당신의 역할은 dbt모델에 들어갈 yml파일을 만드는 것입니다.

'Python > Spark' 카테고리의 다른 글

| 5.3.13 열 결합하기(Concat) (0) | 2025.01.08 |

|---|---|

| 5.3.11 조인(Join) (0) | 2025.01.07 |

| 5.3.9 컬럼 삭제하기(Drop) (0) | 2024.12.25 |

| 5.3.6 널(Null) 값 채우기 (0) | 2024.12.25 |

| 5.1 RDD 생성 (0) | 2024.12.15 |